1. 探索数据集

1.1 数据读入

1 | # 上面是对于数据标签的导入 |

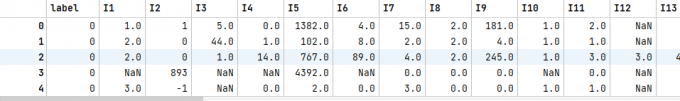

1.2 查看数据

1 | criteo_data.head() |

1 | criteo_data.info() |

1.3 数据分类

1 | # 数据特征分为离散和连续类 |

1.4 查看缺失值情况(标注)

1 | # 查看离散变量目前的类别 |

1 | # 查看连续变量目前的类别 |

1.5 数据分箱

1 | from sklearn.preprocessing import LabelEncoder, OrdinalEncoder, KBinsDiscretizer |

1.6 训练数据与标签分离

1 | # 这里类似于 之前是 标签 + 数据 |

2. 字段维度(field_dim) 与 数据划分

1 | def train_valid_test_split(self, train_size=0.8, valid_size=0.1, test_size=0.1): |

2.1 字段维度获取(field_dim)

1 | # 这一段太妙了 |

2.2 数据划分

1 | train, valid_test = train_test_split(self.data, train_size=train_size, random_state=2021) |